Skuteczna Treść

Jak tworzyć content (nie tylko) pod SEO

Witajcie w nietypowym dodatku! W książce jest rozdział dotyczący tworzenia treści z AI, ale jak zaznaczyliśmy na jego początku – rozwój narzędzi i rozwiązań jest bardzo dynamiczny. Co chwilę pojawiają się kolejne, a te istniejące ewoluują. Opisanie ich wszystkich wraz ze zmianami to temat przynajmniej na jedną osobną książkę i dlatego kwestię jedynie zarysowaliśmy. Mamy też świadomość, że Wam do codziennej pracy nie jest potrzeba historia ani szczegółowe porównanie modeli. Wam potrzebne są wskazówki, jak te narzędzia wykorzystać do ułatwienia obowiązków w codziennej pracy. Treści z książki są dobrym wprowadzeniem w temat. Kwestie dotyczące optymalizacji z narzędziami jak np. Contadu czy SurferSEO nadal są aktualne, ogólne zasady pracy przedstawione w podrozdziale “Jak tworzyć z ChatGPT?” nadal pozostają w mocy i można interpolować je na inne LLMy. Jednak aby Was nie zostawiać tylko z ogólnikami i wyjść poza ograniczenia materiałów drukowanych, mamy dla Was dodatkowy rozdział w postaci online z konkretnymi poradami, jak pracować z narzędziami LLM, ale również jak stawać się źródłem wartościowych informacji dla nich. Wiemy, że to ważny temat. Zapraszamy do lektury!

Jak tworzyć i optymalizować teksty z AI?

Autor: Bartłomiej Tomczyk

- jakie są najpopularniejsze narzędzia LLM i do czego możesz je wykorzystać,

- o co zadbać, aby podnieść szanse na zacytowanie przez LLM jako źródło,

- w jaki sposób AI może pomóc w tworzeniu tekstów,

- na co bezwzględnie uważać podczas pracy z LLM.

Najpopularniejsze narzędzia LLM i do czego są stosowane?

Na samym początku upowszechnienia się modeli LLM niemalże synonimem sztucznej inteligencji, z której może skorzystać każdy użytkownik był ChatGPT. Warto jednak poznać i przetestować różne popularne modele, gdyż twórcy każdego z nich mają nieco inne podejście, przez co sprawdzają się one różnie w konkretnych zastosowaniach.

Najpopularniejsze obecnie narzędzia LLM to:

- ChatGPT – stworzony przez OpenAI chatbot, który rozpoczął rewolucję przystępnej użytkownikowi AI. Wykorzystuje modele GPT – obecnie najczęściej w najnowszej wersji 5, z możliwością użycia starszych. OpenAI uruchomiło również swoją wyszukiwarkę wybudowaną obecnie w ChatGPT.

- Gemini – to odpowiedź Google na popularność ChatGPT. Stanowi obecnie wsparcie dla wyszukiwarki Google w generowaniu odpowiedzi AI Overview oraz AI Mode. Z modelu można korzystać w formie chatbota, ale również poprzez Google AI Studio – bardziej zaawansowane narzędzie, które oprócz chatowania z Gemini pozwala na budowanie aplikacji z AI czy wykorzystanie bardziej specjalistycznych modeli do pracy z grafiką lub wideo.

- Copilot – narzędzie od Microsoftu, wykorzystujące w dużej mierze modele GPT, ale także Claude. Tutaj również mamy możliwość chatowania bezpośrednio na stronie internetowej, ale gigant z Redmond sukcesywnie integruje to narzędzie z innymi swoimi produktami. Copilot pojawia się w wyszukiwarce Bing, systemie Windows i subskrypcjach Microsoft 365.

- Claude – rozwiązanie od firmy Anthropic. Wykorzystuje autorskie LLM, w tym najbardziej znane Sonnet i Opus. Na tle konkurencji wyróżnia się podejściem “Constitutional AI”, czyli trenowaniem modeli w oparciu o zbiór zasad etyki, dbających o szeroko pojęte bezpieczeństwo użytkownika.

- Perplexity AI – rozwiązanie łączące LLM z zaawansowaną wyszukiwarką internetową, które w zależności od potrzeb użytkownika wykorzystuje różne modele językowe, tj. własną modyfikację Llama – Sonar, modele GPT, Claude i inne.

- Llama – OpenSourcowy LLM od Meta. Jest dostępny online jako meta.ai, można go również łatwo pobrać i zainstalować swoim komputerze lub serwerze.

- DeepSeek – OpenSourcowe modele chińskiego startupu o tej samej nazwie. Wydajne i wszechstronne, ale budzące wątpliwości pod kątem bezpieczeństwa danych.

LLM znajdują swoje zastosowanie w wielu dziedzinach życia – od prostego odpowiadania na pytania, przez analizowanie zasobów internetu, po zaawansowane obliczenia, analizy biznesowe i programowanie. W działaniach contentowych oraz SEO modele językowe są stosowane najczęściej do:

- analizy treści istniejących – tworzenia opracowań i streszczeń,

- analizy danych – np. rozbudowanych list słów kluczowych, statystyk stron internetowych,

- przygotowywania planów contentowych – tworzenia list tematów i wytycznych,

- generacji treści na strony internetowej,

- generacji treści publikowanych w social media.

Ponadto, wybrane modele AI (LLM i dyfuzyjne) stanowią istotne wsparcie w tworzeniu i edycji grafik, a także, od niedawna wideo.

Ważne! Niezależnie od tego, z jakiego modelu językowego korzystasz, nie przekazuj mu do analizy i obróbki danych wrażliwych. Mowa tutaj zarówno o danych osobowych, jak i biznesowych. W ten sposób łatwo doprowadzić do wycieku danych, którego skutki trudno przewidzieć. Analizy tego rodzaju danych można przeprowadzać tylko na odpowiednio zabezpieczonych i przetestowanych przez specjalistów systemach, zatwierdzonych drogą procedur wewnętrznych.

Content w dobie AI – jak tworzyć, by być widocznym?

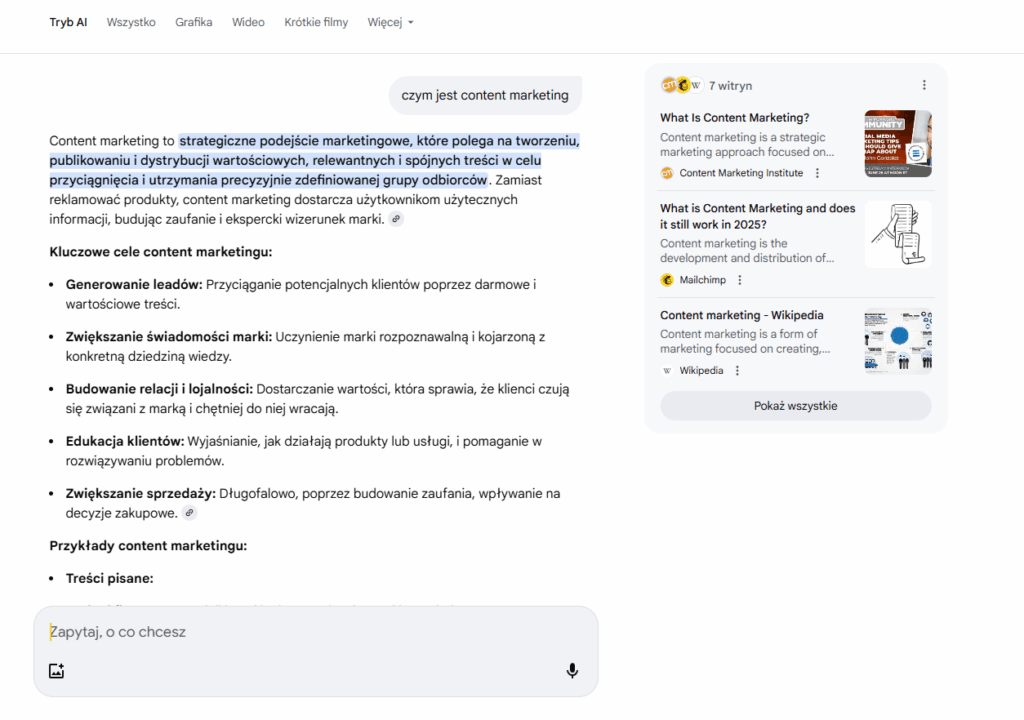

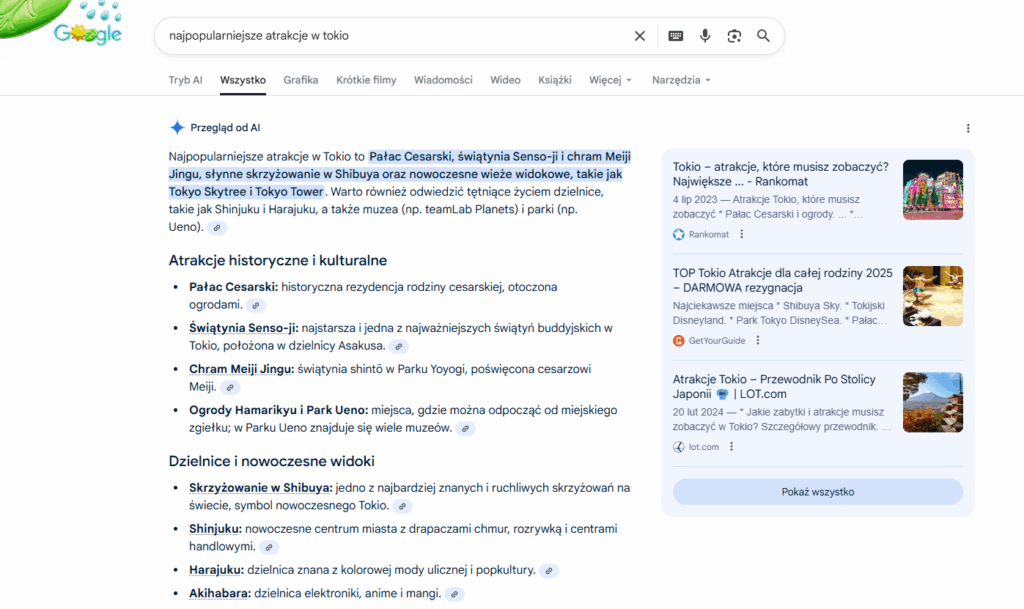

Rozwój narzędzi AI rewolucjonizuje nie tylko tworzenie contentu, ale przede wszystkim jego odbiór. Popularne modele językowe potrafią generować odpowiedzi zarówno w oparciu o “własną”, wcześniej wyuczoną wiedzę, jak i przeszukiwanie w czasie rzeczywistym zasobów internetu. Przeobrażeniu ulega również Google – po wpisaniu zapytania w okno wyszukiwarki możemy skorzystać z podsumowań AI Overviews lub przełączyć się całkowicie w Tryb AI (AI Mode).

Wspólną cechą tych wszystkich systemów jest sposób prezentacji wyników. Nie znajdziemy tam listy linków do stron internetowych, a gotowe podsumowanie z ograniczoną liczbą źródeł, na które powołuje się dane narzędzie. Często lista ta jest umiejscowiona pod koniec odpowiedzi, z boku lub wymaga rozwinięcia.

W znaczący sposób zmienia to podejście do działań SEO i contentowych. Celem staje się nie wyświetlanie w TOP10 wyników wyszukiwania, a doprowadzenie do sytuacji, w której LLM będą powoływać się na tworzone przez nas treści. W porównaniu do standardowych wyników wyszukiwania przejść do strony z takich odpowiedzi jest dużo mniej, ale jeśli już ktoś zdecyduje się na kliknięcie w link do źródła, to jest duża szansa, że jest nim poważnie zainteresowany. Jak zatem pisać, aby AI chciało się na nas powoływać?

Język konwersacyjny – czyli rozmowa z autorem

Podczas korzystania z wyszukiwarek użytkownicy, często z przyzwyczajenia, nie zadają pełnych pytań, a ograniczają swoje zapytanie do kilku słów, które opisują interesujące ich zagadnienie. Niezależnie z jakiego LLM korzystamy, zawsze wita nas okno chatu, a narzędzie staje się przyjaznym asystentem, który chętnie odpowie na zadane pytanie lub zrealizuje powierzone mu zadanie.

Automatycznie więc zaczynamy z naszym pomocnikiem konwersować. W takiej rozmowie nienaturalne jest wykorzystywanie słów kluczowych – pojawiają się więc pytania w formie pełnych zdań, często złożonych, jak podczas spotkania z drugim człowiekiem. LLM w swoich odpowiedziach stara się zwykle dostosować do zaproponowanego tonu i formy rozmowy.

Jako autorzy treści powinniśmy potrafić się w ten trend wpisać. W tekstach, jako ekspert, warto starać się wyczerpać temat i stosować możliwie precyzyjne, konkretne słownictwo. Należy pamiętać o tym, że dla narzędzi AI bardzo ważny jest kontekst, a treść jest analizowana jako sieć powiązań nie tyle pojedynczych słów, co poszczególnych fragmentów tekstu. AI lubi zwięzłe dane oraz raporty z analiz – a mówiąc najprościej:

- liczby,

- listy

- tabele.

Zwykły tekst natomiast powinien być jasno podzielony na wątki, z których każdy warto otwierać odpowiednio oznaczonym w kodzie nagłówkiem. Wszystko to pozwala sztucznej inteligencji uporządkować wiedzę, tworząc powiązania pomiędzy jednym fragmentem tekstu a całą resztą. Poetyckie nawiązania i “malowanie słowem” warto poświęcić dla konkretów. LLM i tak nie zacytuje pełnej wypowiedzi, a raczej ją przetworzy zgodnie z pytaniem użytkownika.

Z drugiej strony jednak nie wolno zapominać o dopasowaniu poziomu skomplikowania języka do odbiorcy. Jeżeli dany artykuł ma trafić do laika, to pomimo bycia najwyższej klasy ekspertem, należy pisać w taki sposób, aby osoba bez wiedzy specjalistycznej to zrozumiała. Stosowanie pojęć fachowych oczywiście nie jest zabronione, ale jeśli będzie ich za dużo, mogą one zniechęcić LLM do powołania się na artykuł, tak jak czytelnik zniechęca się gdy widzi trudne dla niego słowa. Jeśli jednak tekst jest skierowany do profesjonalistów, można podnieść poziom, ale należy wówczas liczyć się z tym, że będzie on miał węższe grono odbiorców.

Długość artykułu nie jawi się obecnie jako istotne kryterium, ale warto pamiętać o istotnym trendzie – im bardziej kompleksowo omówione jest zagadnienie, tym więcej cytowań przez AI. Więc niejako automatycznie dłuższa, merytoryczna treść będzie częściej pojawiać się w wynikach generowanych przez LLM.

Pytanie – odpowiedź – może niekoniecznie krótko, ale na temat

Uporządkowana i prawidłowo zakodowana struktura treści jest bardzo ważna, ale aby wpisać się w styl AI warto starać się utrzymać podejście na zasadzie pytań i odpowiedzi. Nagłówek danej sekcji dobrze jest przygotowywać w formie pytającej – najlepiej na podstawie pytań pozyskanych w ramach analizy słów kluczowych. Początek akapitu otwierającego sekcję powinien stanowić krótką, zwięzłą odpowiedź na pytanie zadane w nagłówku.

Nie oznacza to jednak, że każdy artykuł ma wyglądać jak sekcja FAQ. Wspomnianą odpowiedź należy przygotować w taki sposób, aby sama w sobie miała sens (czyli mogła być “pożyczona” przez LLM), ale jednocześnie sugerowała że temat jest znacząco bardziej złożony i warto zagłębić się w tekst całej sekcji. A tam można już szerzej opisać całe zagadnienie, najlepiej wplatając dodatkowo wspomniane już listy, tabele oraz dane liczbowe.

W kontekście AI nie ulega zmianie znaczenie znacznika <strong> – warto wyróżniać przy jego pomocy najważniejsze fragmenty w danej sekcji tekstu. Oczywiście z umiarem, aby nie doprowadzić do sytuacji typu “tutaj wszystko jest ważne”, ponieważ automatycznie obniży to wartość tego wyróżnienia.

Podpisz się pod tekstem – czyli jeszcze więcej EEAT!

Przy okazji omawiania w książce podstawowych cech dobrych treści pojawiło się pojęcie EEAT (experience, expertise, authoritativeness, trustworthiness). O ile w kontekście “tradycyjnych” wyników wyszukiwania znaczenie tych czynników od dłuższego czasu wzrastało, o tyle w dobie AI są uznawane za obowiązkowe.

Kontekst artykułu to bowiem nie tylko jego treść, ale także autor. Osoba wymieniona z imienia i nazwiska, najlepiej w połączeniu z portfolio innych treści przez nią przygotowanych. AI preferuje materiały tworzone przez rzeczywiste osoby z doświadczeniem w dziedzinie, której dotyka dany tekst.

W jaki sposób udowodnić eksperckość autora? Możliwości jest bardzo wiele:

- stale rozbudowywana lista artykułów na naszej stronie,

- publikacje gościnne na innych stronach internetowych,

- gościnne wypowiedzi, np. w formie wstawek podpisanych imieniem, nazwiskiem oraz oczywiście nazwą naszej firmy,

- profil w social media – z postami / publikacjami powiązanymi tematycznie z branżą,

- cytowania,

- autorstwo lub współautorstwo artykułów, ebooków lub książek, które będą wspominane w internecie lub będą pojawiać się w bibliografiach innych autorów.

Lista jest bardzo długa i oczywiście autor idealny będzie spełniał wszystkie te punkty, ale na wszystko przyjdzie czas. Na start warto pamiętać o jednym – koniec z anonimowością, pokazujmy szerszej publice naszych ekspertów.

Sygnały z zewnątrz

Szeroki zakres możliwości budowy autorytetu autora tekstu wprowadza nas w kolejny wątek – pozyskiwanie sygnałów z zewnątrz. Wątek postaci stojącej za artykułem mamy już omówiony, ale należy również pamiętać o pozyskiwaniu odwołań do samej treści.

Z powodzeniem zastosować tutaj można dobrze znany w SEO model pozyskiwania linków przychodzących, np. w postaci artykułów sponsorowanych z odnośnikiem. Bardzo ważna będzie tutaj jednak wartość portalu, z którego pochodzi link – nie tylko w wymiarze wskaźników tj. widoczność, ruch, Domain Rating czy Domain Authority, ale przede wszystkim tego, czy narzędzia AI “lubią” się na dany portal powoływać.

Gdyby jednak chodziło o linki, ten fragment nie nazywałby się “Sygnały z zewnątrz”, a po prostu tradycyjnie “Linkbuilding”. Schemat działania LLM otwiera bowiem nową formę, a mianowicie wzmianki. Dla algorytmów sztucznej inteligencji istotne będzie czy i w jakim kontekście w internecie pojawia się wspomniany już autor oraz sama treść publikacji. Wartościowe stają się więc:

- cytaty z powołaniem się na konkretny artykuł i autora,

- obecność artykułu w źródłach innych publikacji.

Oczywiście link obok powołania się przyda, ale dla AI nie jest obowiązkowy.

Powoływanie się na źródła

Kolejnym istotnym elementem budowania wartości naszej treści jest powoływanie się na wartościowe źródła zewnętrzne. Jest to jeden z czynników, który tworzy jakościowe powiązania merytoryczne dla artykułu. Pomaga to odróżnić content warty cytowania od zlepków losowych stwierdzeń, niepopartych faktami.

W tym procesie należy pamiętać, że narzędzia AI z dużą dozą prawdopodobieństwa mają dostęp do źródeł, na które się powołujemy lub chociaż znają ich autorów z obecności w internecie. Jeśli więc źródło nie znajdzie odzwierciedlenia w merytoryce naszego tekstu, nie ma sensu go przywoływać – bo takie “manipulacje” nie wnoszą żadnej wartości.

Zdecydowanie warto więc przygotowywać mini-bibliografie artykułów, a w treściach powoływać się na dane z raportów lub cytować ekspertów.

Dane strukturalne – kolejne ułatwienie dla algorytmów

Jeśli naszym celem jest “zachęcenie” botów i algorytmów narzędzi AI do crawlowania oraz wykorzystywania treści ze strony, warto podjąć wysiłek by maksymalnie ułatwić im pracę. Jednym z elementów doprecyzowujących rodzaj i kluczowe informacje o treści są dane strukturalne Schema.org. Pozwalają one w sposób uporządkowany (inną nazwą danych strukturalnych są właśnie dane uporządkowane) przekazać botom informacje o m.in.:

- naszej firmie – jej nazwie, krótkiej charakterystyce, logo, adresie fizycznym i danych kontaktowych,

- oferowanych produktach i usługach – ich nazwie, cenie, charakterystyce, ocenie i opiniach kupujących,

organizowanych eventach, - artykułach – ich tytule, autorze, dacie publikacji i aktualizacji,

a także wielu innych aspektach, jak np. tym czy na danej podstronie znajduje się sekcja FAQ, oferty pracy, wideo, lista kursów czy może… przepis na smaczne danie.

Możliwości jest bardzo wiele – przygodę z danymi strukturalnymi warto rozpocząć od informacji zawartych w Google Search Central. Następnie, aby poszerzyć wiedzę można przenieść się na stronę Schema.org. Nie oznacza to, że niezbędne jest wdrożenie wszystkich możliwych dla danej strony danych strukturalnych. Konieczne są te podstawowe, dające jasny sygnał o czym mowa na konkretnej podstronie, ile kosztuje dany produkt lub jakie opinie mają o nim kupujący.

Inne aspekty techniczne i nie tylko

Warto pamiętać, aby nie oddzielać znajdujących się w tym rozdziale rekomendacji od innych zaleceń, które pojawiają się w książce. Wysokiej jakości, dobrze zoptymalizowana treść ma szanse być wysoko oceniona zarówno przez boty wyszukiwarek, jak i AI. W momencie przygotowywania tej treści Google w zaleceniach SEO w Google Search Central wskazywało, że nie powstały żadne dodatkowe wymagania dotyczące wyświetlania stron w AI Overviews oraz AI Mode.

Podstawą jest więc dostępność treści dla botów – nie tylko Google, ale też innych narzędzi AI – warto pod tym kątem sprawdzić plik robots.txt. Content powinien być również osadzony w nawigacji w taki sposób, aby dotarcie do niego było łatwe zarówno dla użytkowników, jak i botów crawlujących zasoby internetu.

Nie zapominajmy również o aktualności treści. Chodzi tutaj przede wszystkim o dostarczanie możliwie najnowszej wiedzy, a także o transparentne przedstawianie daty publikacji oraz aktualizacji artykułów (wraz z odpowiednimi danymi strukturalnymi).

AI wsparciem w codziennej pracy

LLM mogą być również naszymi asystentami, którzy pomogą przygotować content na stronę internetową. Słowo “asystentami” jest tutaj kluczem, bo sztuczna inteligencja nie zastąpi ani wiedzy i doświadczenia eksperta, ani kompetencji copywritera lub dziennikarza. Jakość treści wygenerowanej przez AI zależy w dużej mierze od danych wejściowych dostarczonych przez jej użytkownika. Im bardziej precyzyjny i merytoryczny wsad, tym mniej miejsca na błędy i halucynacje.

Najpierw kontekst, potem zadanie

Sama prośba typu “napisz artykuł na 4000 znaków na temat modnych butów damskich” zdecydowanie nie wystarczy. Niezbędne jest przygotowanie podstaw – roli, w którą nasz asystent ma się wcielić.

Początek promptu lub pierwsza jego iteracja powinny więc zawierać następujące informacje:

- “kim” jest model – np. copywriterem z dużym doświadczeniem w branży modowej, ekspertem w dziedzinie księgowości, profesorem uczelnianym zajmującym się naukami społecznymi,

- gdzie zostanie umieszczony tekst – np. tekst na bloga sklepu z luksusową odzieżą damską,

- do kogo tekst jest skierowany – np. do potencjalnych klientów zainteresowanych zakupem samochodu używanego, młodych mam poszukujących akcesoriów do pokoju córeczki,

- w jakim tonie powinien zostać przygotowany materiał – np. w tonie luźnym, przyjacielskim, z punktu widzenia eksperta lub delikatnie zachęcającym do zakupu nowego produktu,

- jakich sformułowań używać, jakich bezwzględnie unikać.

Dopiero w drugiej części promptu lub jego kolejnej iteracji (czyli po potwierdzeniu przez LLM, że rozumie kontekst zadania) można przejść do opisywania właściwego zadania. Dzięki temu AI będzie mieć mniej swobody i szanse, że stworzy bezużyteczny tekst spadną.

Przykładowy prompt – opis kontekstu zadania

Jesteś doświadczonym copywriterem specjalizującym się w marketingu internetowym i reklamie cyfrowej, z wieloletnim doświadczeniem w tworzeniu treści dla firm z branży e-commerce i agencji marketingowych.

Twoim zadaniem jest przygotowanie artykułu blogowego na stronę agencji marketingowej specjalizującej się w kampaniach online (Google Ads, Meta Ads, TikTok Ads).

Tekst będzie skierowany do właścicieli małych i średnich firm, którzy rozważają inwestycję w reklamę internetową, ale nie są jeszcze przekonani co do jej skuteczności.

Przygotuj tekst w tonie eksperckim, ale przystępnym – ma edukować i budować zaufanie do wiedzy autora. Unikaj nadmiernego żargonu marketingowego, tłumacz pojęcia w prosty sposób. Styl ma być profesjonalny, ale nie sztywny – z lekkim akcentem doradczym i zachęcającym do działania.

Zalecenia językowe:

- Używaj konkretnych przykładów (np. kampania Google Ads dla sklepu z obuwiem sportowym).

- Stosuj nagłówki H2 i H3, które pomagają w SEO (np. „Dlaczego reklama w internecie się opłaca?”, „Jak dobrać odpowiedni kanał reklamowy?”).

- Unikaj pustych frazesów typu „Internet daje nieograniczone możliwości” lub „Każda firma powinna być online”.

- Zamiast tego, używaj danych, korzyści i praktycznych wskazówek.

- Nie pisz w stylu nachalnej reklamy – tekst ma być merytoryczny, nie sprzedażowy.

Na końcu dodaj krótkie podsumowanie oraz wezwanie do działania w formie zaproszenia do kontaktu z agencją (bez przesadnej presji).

Poszukiwanie tematów treści – na co uważać?

Sztuczna inteligencja może z powodzeniem pomóc nie tylko w tworzeniu treści, ale również krok wcześniej – na etapie analizy, co warto napisać. Dobrze poinformowana AI jest w stanie zaproponować naprawdę ciekawe tematy blogowe.

Tutaj również niezmiernie ważny będzie kontekst, warto poinformować LLM o przynajmniej kilku z tych aspektów:

- jaka jest tematyka naszej strony internetowej – można również wskazać jej adres, by bot zapoznał się z treścią strony głównej,

- jaka tematyka wpisów nas interesuje – np. związana z najważniejszą kategorią produktów lub konkretną usługą, bardziej lifestyle albo ekspercka,

- kto będzie adresatem wpisów – np. czy będzie to laik czy osoba obeznana w temacie,

- jaki jest cel wpisu – np. zachęcenie do zakupu produktu, “podsunięcie” potencjalnemu klientowi usługi lub po prostu dzielenie się wiedzą.

Co więcej, jeśli tylko istnieje taka możliwość, warto do promptu dołączyć listę obecnie opublikowanych na blogu tematów oraz słów kluczowych – zarówno tych, na które strona jest widoczna, jak i tych, które nas biznesowo interesują (jeśli mamy wybrane).

Przykładowy prompt – budowa listy tematów

Jesteś strategiem content marketingowym i doświadczonym copywriterem specjalizującym się w branży digital marketingu.

Pomagasz agencjom marketingowym planować skuteczne treści blogowe, które wspierają SEO, budują wizerunek eksperta i generują leady sprzedażowe.

Twoim zadaniem jest przygotowanie 10 propozycji tematów artykułów blogowych dla strony internetowej agencji marketingowej.

Kontekst:

- Agencja zajmuje się reklamą online (Google Ads, Meta Ads, TikTok Ads), SEO, content marketingiem i analityką internetową.

- Blog ma być miejscem edukacji przedsiębiorców i marketerów, którzy szukają praktycznych porad dotyczących promocji firm w internecie.

Tematyka wpisów:

- skoncentrowana na strategiach marketingowych, efektywności kampanii i trendach w reklamie online,

- z naciskiem na praktyczne wskazówki, porównania narzędzi i analizy przypadków (case studies),

- styl: ekspercki, ale przystępny dla przedsiębiorców, którzy nie są specjalistami od marketingu.

Adresaci:

Właściciele małych i średnich firm, menedżerowie e-commerce, osoby odpowiedzialne za marketing w firmie, które chcą lepiej rozumieć działania agencji i samodzielnie oceniać efekty kampanii.

Cel wpisów:

- budowanie wizerunku agencji jako eksperta w marketingu internetowym,

- zwiększanie ruchu organicznego (SEO),

- zachęcanie potencjalnych klientów do kontaktu i współpracy,

- edukacja odbiorców poprzez praktyczne treści.

Zalecenia dotyczące stylu:

- używaj języka korzyści i konkretów,

- propozycje tytułów powinny być atrakcyjne, zrozumiałe i SEO-przyjazne,

- unikaj clickbaitów i ogólników,

- każdy temat może zawierać krótkie uzasadnienie, dlaczego warto go opisać (1–2 zdania).

Zaproponowane tematy należy poddać własnej krytycznej analizie. Nawet pomimo dostarczenia tematów obecnych już na stronie tekstów oraz list fraz, AI może przygotować tematy, które spowodują zjawisko duplikacji i kanibalizacji treści. Co więcej, LLM nie są w stanie bez odpowiednich danych wejściowych przeprowadzić analizy słów kluczowych, więc zaproponowane tematy mogą wyglądać ciekawie, ale nie mieć wartości z punktu widzenia SEO i innych działań marketingowych.

Przykład

Dobrym przykładem będzie tutaj zlecenie wygenerowania pomysłów na teksty blogowe dla lokalnej sali zabaw w Warszawie. W prompcie zaznaczono m.in.:

Przygotuj pomysły na teksty blogowe dla Sali Zabaw ABC w Warszawie. Teksty mają być dopasowane do lokalizacji (Warszawa), grupy odbiorczej (rodzice małych dzieci) oraz specyfiki biznesu (sala zabaw). Nie mogą promować konkurencji.

Wśród propozycji znalazły się następujące tematy z zaleceniami:

Tekst nr 1

Temat: Co robić z dzieckiem Warszawie gdy pada deszcz? Wybierz Salę Zabaw ABC.

W konspekcie pojawiła się sugestia by opisać “najlepsze sale zabaw w Warszawie dla dzieci w różnym wieku”.

Tekst nr 2

Temat: Organizacja urodzin dla dzieci w Warszawie. Wybierz Salę Zabaw ABC!

W konspekcie pojawiła się sugestia by opisać “najlepsze miejsca na urodziny dla dzieci – ranking”.

Tekst nr 3

Temat: Pomysły na aktywne popołudnie z dzieckiem w Warszawie. Zapraszamy do Sali Zabaw ABC!

W konspekcie pojawiła się sugestia by opisać “porównanie sal zabaw z Warszawy”.

Przede wszystkim, tematy są ogólne, ale z sugestią zawężenia do tej konkretnej sali zabaw. W związku z tym nie będą niosły realnej wartości dla odbiorcy, ponieważ realnie nie będzie tam informacji, jak na różne sposoby można spędzić czas z dzieckiem czy gdzie zorganizować urodziny. Dodatkowo każdy tekst sugeruje opisanie sali zabaw, czyli chcąc nie chcąc, po kilka razy innymi słowami będą opisane atrakcje i ich zalety. A wisienką na torcie jest promowanie konkurencji w ramach opisów. Tak, LLMy potrafią przeczyć same sobie.

Zacznij od planu

Mamy już przygotowane tematy, wiemy w jaki sposób przygotować AI do wcielenia się w rolę autora treści. Teoretycznie można by było już na tym etapie połączyć kontekst z tematem w jeden prompt i zlecić naszemu wirtualnemu asystentowi pracę nad tekstem. Jednak aby zyskać jeszcze większą kontrolę nad treścią, warto wykonać krok pośredni, a mianowicie poprosić LLM o przygotowanie planu, na podstawie którego zostanie przygotowany artykuł.

To dobry moment, aby z AI podzielić się następującą wiedzą:

- tematem wpisu,

- zagadnieniami, które koniecznie chcemy poruszyć w tekście,

- słowami kluczowymi, które w toku analizy fraz dopasowaliśmy do artykułu,

- długością artykułu,

- źródłami, które warto wykorzystać w przygotowaniu materiału.

Jesteś strategiem content marketingowym i doświadczonym copywriterem specjalizującym się w marketingu internetowym oraz SEO copywritingu. Twoim zadaniem jest przygotowanie szczegółowego briefu treści w punktach dla artykułu blogowego na temat:„Reklama w internecie – jak działa i dlaczego warto w nią inwestować?”

Cel artykułu

- edukować właścicieli małych i średnich firm na temat zasad działania reklamy online,

- pokazać jej zalety w porównaniu z tradycyjnymi formami reklamy,

- zbudować świadomość, że reklama internetowa to inwestycja, nie koszt,

subtelnie zachęcić do skorzystania z usług agencji marketingowej.

Grupa docelowa

- właściciele firm z sektora MŚP, którzy rozważają rozpoczęcie działań promocyjnych w internecie,

- osoby prowadzące e-commerce lub lokalne biznesy usługowe,

- czytelnicy niebędący ekspertami od marketingu — potrzebują prostych, zrozumiałych wyjaśnień.

Zakres zagadnień do omówienia – zależy mi na wspomnieniu o:

- Dlaczego warto inwestować w reklamę online – mierzalność efektów, precyzyjne grupy docelowe, elastyczność budżetu, skalowalność.

Porównanie reklamy internetowej z tradycyjną – zalety, koszty, efektywność. - Jak dobrać odpowiedni kanał reklamowy dla swojej firmy – krótki przewodnik po wyborze platformy.

- Jak mierzyć efekty kampanii – podstawowe wskaźniki (CTR, ROAS, konwersje).

Zlecenie przygotowania briefu treści w punktach będzie dobrym sposobem na zweryfikowanie, czy AI dobrze rozumie zapytanie oraz w jaki sposób wykorzysta wiedzę “własną” oraz pochodzącą ze źródeł. Warto dodać również, aby na w ramach briefu pojawiły się słowa kluczowe oraz źródła – ułatwi to przygotowanie promptu generującego właściwą treść.

Tworzenie treści – krok po kroku lub w całości

Posiadając cały pakiet wcześniej wymienionych informacji, można przystąpić do przygotowywania właściwego tekstu. Jeśli pracowaliśmy z modelem iteracyjnie, dostarczając wiedzę krok po kroku, można od razu zlecić jej przygotowanie treści, jeśli tworzyliśmy prompt etapami, należy zebrać razem:

- informacje o kontekście,

- temat lub tytuł wpisu,

- cel treści i grupę docelową,

- wygenerowany brief z planem artykułu, frazami i źródłami, ewentualnie zalecaną długością.

Na tym etapie również można zastosować dwa podejścia – albo zlecać przygotowanie tekstu punkt po punkcie według briefu, albo od razu cały artykuł. Pierwsza opcja ponownie daje większą kontrolę – łatwiej zauważyć moment, w którym AI zaczyna “odpływać” od pierwotnych założeń. Druga z metod jest po prostu szybsza.

Niezależnie od tego, jak dokładny był prompt i jak głębokie analizy wstępne – finalną treść zawsze powinien zweryfikować człowiek. Istnieje wiele aspektów, w których AI może popełnić błąd:

- poprawność merytoryczna,

- powoływanie się na nieistniejące źródła,

- wykorzystanie sformułowań, które nie pasują do linii komunikacji marki,

- podanie nieadekwatnych przykładów.

W skrócie mówiąc – AI może napisać nieprawdę i z wysoką pewnością siebie próbować ją udowodnić. Jako przykłady jest w stanie zaprezentować głównych konkurentów lub wprost ich zacytować, jeśli podaliśmy ich strony internetowe jako wartościowy przykład.

Możliwości automatyzacji pracy

Praca z modelami językowymi oparta o ręczne wprowadzanie promptów to jednak dopiero początek możliwości sztucznej inteligencji. LLM w bardzo funkcjonalny sposób mogą być wykorzystywane przez narzędzia do automatyzacji tj. m.in. Make, Zapier, n8n czy Pipedream. Łącząc za ich pomocą AI z:

- narzędziami do przechowywania danych – bazami danych czy chociażby arkuszami lub dokumentami Google,

- API popularnych narzędzi SEO, tj. Senuto, Ahrefs czy Semrush,

narzędziami analitycznymi tj. Google Analytics czy Google Search Console, - generowaniem zapytań do różnych stron internetowych,

można przygotować workflow, który wykona większość pracy za nas. Każde z narzędzi automatyzujących ma swoją specyfikę, ale pozwalają one na przygotowanie promptów, które będą automatycznie wysyłane do wybranego LLM, a następnie przetworzenie ich odpowiedzi do pożądanej postaci.

Jeśli więc planujesz szeroko zakrojony projekt tworzenia treści, możesz rozważyć automatyzację:

- analizy widoczności i słów kluczowych – koniecznie w oparciu o rzeczywiste dane z narzędzi, a nie “pomysły” AI,

- przygotowania briefów,

- pisania właściwych artykułów,

- a nawet wczytywania ich do CMS strony – koniecznie jako szkic!

Ponownie, kluczowe w całym procesie jest, aby finalne kliknięcie “Opublikuj” pozostawić człowiekowi. Nie wolno doprowadzać do sytuacji, w której sztuczna inteligencja sama stworzy i sama opublikuje treść. Ryzyko błędów jest zbyt wysokie, a ich obecność może zaważyć na wizerunku marki i kojarzących się z nią ekspertów.

AI w praktyce

- Narzędzia LLM to dużo więcej niż znany powszechnie ChatGPT.

Podczas tworzenia treści na swoją stronę pamiętaj o języku konwersacyjnym – formie pytań i odpowiedzi. - W dobie AI pojęcie EEAT ma coraz większe znaczenie.

Wartościowy tekst to taki, który powołuje się na wartościowe źródła i sam (lub jego autor) jest cytowany lub stanowi źródło dla innych tekstów. - Pamiętaj o optymalizacji technicznej strony.

Przygotowując tekst z pomocą LLM dostarcz jak najwięcej informacji dotyczących kontekstu treści, jej celu oraz źródeł, z których warto korzystać. - Bezwzględnie unikaj przekazywania AI danych wrażliwych – zarówno biznesowych jak i osobowych. Wyjątkiem są odizolowane modele, zweryfikowane przez specjalistów bezpieczeństwa.

- AI traktuj jako asystenta, a nie autora – weryfikację i publikację każdej treści należy pozostawić człowiekowi.