Za nami kolejny, naładowany potężną dawką wiedzy webinar od Senuto. Pozostajemy w tematyce zdobywania praktycznych umiejętności z zakresu sztucznej inteligencji. Dobrze wiemy, że AI ma większy lub mniejszy wpływ na naszą codzienność i jedyne, co możemy z tym zrobić, to nauczyć się korzystać z niej w praktyce. Sprawdźmy, jakie nowe wyzwania i możliwości zostały omówione przez ekspertów z dziedziny Prompt Engineering.

Spis treści:

- Model językowy – kilka słów o teorii

- Główne różnice pomiędzy GPT w przeglądarce, a API

- Praktyczne wskazówki wykorzystania różnych wersji chatGPT

- Eksploracja i eksperymenty

- Podsumowanie

Model językowy – kilka słów o teorii

W dzisiejszych czasach teoria i praktyka wykorzystania zaawansowanych modeli językowych, takich jak GPT-3.5, gwarantują niezwykłe możliwości komunikacji i tworzenia treści. Rewolucjonizują sposób, w jaki oddziałujemy z maszynami. Czym jednak są te modele, jakie są ich różnice, a przede wszystkim – jak wykorzystać je w praktyce?

Każdy model językowy jest zbudowany na bazie sieci neuronowych. To zaawansowane techniki, które umożliwiają sztucznej inteligencji analizowanie, generowanie i rozumienie treści. Są zainspirowane biologicznymi połączeniami, które przetwarzają informacje w mózgu.

Wielkość Modelu Językowego – jak ją liczyć?

Możemy wymienić dwie główne cechy sztucznej inteligencji:

- Liczba parametrów – to wagi, które zostały dostosowane podczas procesu uczenia się modelu na zbiorze danych tekstowych. Pozwalają generować odpowiedzi, tworzyć teksty i wykonywać różnorodne zadania związane z językiem naturalnym. Większa liczba parametrów oznacza, że model jest bardziej złożony. Głównie mają wpływ na:

– Wynik – im jest ich więcej, tym jest on dokładniejszy.

– Wykorzystanie – modele o mniejszej ilości są wystarczające do tworzenia prostszych treści.

– Szybkość działania – modele o większej ilości parametrów mogą działać wolniej.

- Liczba tokenów – to podstawowe jednostki, na które jest dzielony tekst. Tokenem może być pojedynczy znak, słowo lub jego fragment; przyjmuje się, że token to średnio 4 znaki w języku angielskim. Każdy model ma własny sposób na tokenizację, czyli podział tokenów. Modele językowe o większej ilości tokenów mają potencjał do przetwarzania dłuższych fragmentów.

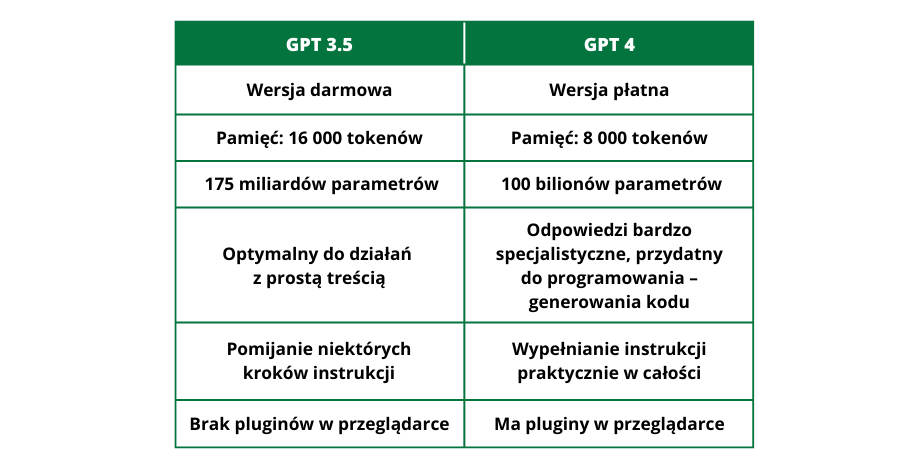

Różnice między GPT-4 a GPT-3.5

Obecnie na rynku dostępne są dwie wersje czatu i każda z nich ma swoje zastosowanie. Przyjrzyjmy się różnicom pomiędzy modelem GPT-4 a jego poprzednikiem, GPT-3.5. Modele takie jak DaVinci, choć kiedyś popularne, obecnie tracą na znaczeniu. GPT-3.5 oferuje jakość wystarczającą do wielu zastosowań, takich jak pomoc przy optymalizacji SEO czy dostosowanie się do podstawowych zapytań, jednak to nowszy model jest wskazany, gdy potrzebujemy specjalistycznych odpowiedzi, wygenerowania kodu lub opisania bardziej złożonych scenariuszy. Różnica leży nie tylko w ilości tokenów, ale także w zdolności GPT-4 do dokładniejszego śledzenia bardziej złożonych poleceń.

Dla lepszego zobrazowania tematu porównajmy możliwości chatGPT-3.5 i chatGPT-4.

Główne różnice pomiędzy GPT w przeglądarce, a API

Odwiedzając świat zaawansowanych modeli językowych trafiamy także na inne rozwiązania, widoczne i. in. w różnicach między interfejsem API a przeglądarkowym. Te systemy nie są ze sobą połączone, a API nie jest tak często aktualizowane. Pamiętajmy, że nigdy nie uzyskamy dwóch takich samych odpowiedzi od API i z przeglądarki.

Należy pamiętać, że interfejs przeglądarkowy chatGPT, a API to dwa różne systemy. Różne są także ich specyfikacje:

- Zdefiniowane parametry – w API definiujemy je sami, przeglądarkowy interfejs narzuca nam je odgórnie.

- Moderowanie odpowiedzi – chatGPT ma pewne narzucone reguły moderowania odpowiedzi, których nie ma API – trzeba to robić za pomocą dostępnych narzędzi i własnej wiedzy.

- Pole system – w chatGPT w przeglądarce rolę, w którą ma się wcielić AI nadajemy bezpośrednio w prompcie. Dzięki temu jego odpowiedzi są bardziej sprecyzowanie.

- Function Calling – funkcja w API, która pozwala na przekazywanie danych z odpowiedzi chatGPT do funkcji, którą zdefiniowaliśmy. Najpierw definiujemy tę funkcję i jej pola, a następnie prosimy chatGPT, aby przekazał parametry z prompta do tej funkcji.

- Playground API – Oferowany przez OpenAI Playground to miejsce zabawy z modelem, gdzie użytkownik porozumiewa się bezpośrednio z kodem, pomijając filtry, których używa chat GPT. Możemy nadać AI rolę i temperaturę – czyli pozwolić na mniejszą lub większość kreatywność – kontrolując tym samym stopień losowości generowanych odpowiedzi. Zadajemy pytania za pomocą promptów tak samo jak w przypadku pozostałych interfejsów.

Ciekawostką jest to, że wskazówki, jak poradzić sobie z interfejsem API, można znaleźć wykorzystując sam model GPT. Po zadaniu odpowiednich pytań GPT krok po kroku przeprowadzi użytkownika przez cały proces.

#Protip: jeśli zależy nam na wygenerowaniu kilku wersji tego samego tekstu, to wystarczy zmieniać wartość parametru temperatura. Oczywiście, zachowując zdrowy rozsądek 😉

Praktyczne wskazówki wykorzystania różnych wersji chatGPT

Czas na praktykę, bo tylko w ten sposób można wypracować swój system pisania promptów. Zaczynając swoją przygodę, warto bazować na wiedzy i doświadczeniach ekspertów z tej dziedziny, tym bardziej że tak chętnie dzielą się wiedzą.

Artykuł w API krok po kroku

Maciej Chmurkowski podzielił się z nami własnym przepisem na konwersację z modelem językowym – jako przykład wykorzystał napisanie artykułu na podstawie jednego słowa kluczowego, używając do tego zadania Playground API.

- Pole system uzupełniamy w taki sposób, aby wybrać styl pisania modelu. Wskazujemy, w jaką rolę powinien się wcielić (webdeveloper, doświadczony specjalista SEO, copywriter).

- W parametrach określamy model (w tym przypadku: GPT-4).

- Pole zapytania: zaczynamy od podstaw – „napisz tytuł artykułu o tematyce..” i uzupełniamy o wytyczne, takie jak styl pisania, kontekst, czy użycie porównań. Takie działania przybliżą otrzymaną odpowiedź do naturalnego języka.

- Otrzymany tytuł – o ile jest dla nas zadowalający – zostaje punktem wyjściowym do dalszego działania.

- Kolejne zapytanie dotyczy wygenerowania title i meta description do wcześniej stworzonego tytułu.

Uwaga! Jeśli chcemy, aby chcemy, aby GPT zwrócił nam odpowiedź w innym formacie, np. JSON, to należy użyć indeksu.

Przykładowo: meta description {meta_desc}

W momencie, kiedy nie zdefiniujemy indeksów do formatu JSON, GPT może wygenerować różne indeksy i tego nie da się tego poprawić mając cały skrypt.

#Protip: jeśli API urwie odpowiedź, to w formacie JSON rozpoznamy, że jest ona niedokończona.

- Otrzymujemy odpowiedź w formacie JSON. Widzimy, że jest pełna dzięki klamerce zamykającej. Teraz możemy jej użyć w kodzie.

Na tym można zakończyć pracę, ale wciąż można kontynuować eksperymenty – zmieniać polecenia w polu system, poprosić plan pokrewnych zagadnień lub wygenerowanie nagłówków w formacie HTML.

#Protip: generując treść do każdego nagłówka, róbmy to osobno do każdego z nich. Unikniemy bezsensownych powtórzeń, a przy tym zaoszczędzimy trochę tokenów.

#Protip2: jeśli wiemy, co dokładnie ma się znaleźć w treści, przekażmy to w kwadratowych nawiasach.

Aby artykuł nie był suchym tekstem możemy poprosić chatGPT o wygenerowanie tzw. wartości dodanej dla użytkownika – wykresu, tabelki w formacie, który będziemy mogli bezpośrednio umieścić na stronie internetowej, czyli w kodzie.

#Protip: Pamiętajmy, że prosząc o wykres w formacie, który możemy wkleić na stronę musimy zmienić zawartość pola system, narzucając modelowi rolę webdevelopera.

Ciekawostka: Możemy poprosić w promptcie o wygenerowanie prompta. Mając tekst bezpośrednio od chatGPT, w którym proponuje treść – korzystamy z tego. Trzeba jednak uważać, żeby uniknąć pojawiających się błędów modelu.

Jak zagwarantować sobie treść wysokiej jakości?

Tomasz Jeska podzielił się z nami nieco innym rozwiązaniem. Wykorzystując możliwości chatGPT-3.5 turbo w API od OpenAI stworzył jeden skrypt, który pozwolił na wygenerowanie długiego tekstu – około 30 000 znaków. Ale co ważniejsze – tekst bez powtórzeń, parafraz i innych zapętleń.

Jak to uczynił?

- Narzucamy modelowi kim jest i jaką treść ma stworzyć. Najlepiej, żeby to były tytuły akapitów lub krótkie rozwinięcia tematów, z których chcemy stworzyć artykuł.

- Mając pobieżne treści, wrzucamy je do nawiasów – […] – tym samym przypisując je do tematów, z których dany artykuł na się składać.

a. Wstęp [treść]

b. Temat 1 [treść]

c. Temat 2 [treść]

d. Podsumowanie – krótka podpowiedź jak ma wyglądać akapit.

Tworzymy tyle tematów, ile potrzebujemy – tematem mogą to być pojedyncze słowa. Ważne, żeby były ze sobą spójne, a nawet „nachodziły” na siebie tematycznie.

- Czas na prompt. Podtrzymujemy nadaną funkcję chatGPT oraz prosimy o wygenerowanie spójnej, wyczerpującej treści na podstawie stworzonych powyżej sekcji. Pamiętajmy, żeby zawrzeć informacje o tym, że tekst powinien zostać wygenerowany w formacie HTML. Jeśli ma być to treść zoptymalizowana pod wyszukiwarki, warto to uwzględnić.

- Jeśli odpowiedź nas zadowala, kopiujemy i uruchamiamy skrypt w rozszerzeniu HTML.

Teraz już nikt nie powie, że się nie da 😉

Optymalizacja promptów

Damian Sałkowski z Senuto sprzedał nam patent, jak optymalizować prompty, aby były przyjazne dla chatGPT – korzystanie z samego chatu w celu optymalizacji.

- W pierwszym zapytaniu narzucamy GPT, że ma zachowywać się jak Prompt Optimizer.

- Wpisujemy, że przekażemy mu nasz prompt do chatGPT oraz chcemy, aby zadał nam kilka pytań, które pomogą zoptymalizować to zapytanie.

- Wpisujemy prompt i czekamy na odpowiedź, w której powinny zawierać się pytania od chatGPT.

Przykładem, którym posłużył się Damian był prompt do wygenerowania planu contentu SEO, zgodnego z danym tematem, z wykorzystaniem podanych słów kluczowych, podaną ilością nagłówków itd. GPT w tym momencie zadaje nam pytania, które pozwolą mu jak najbardziej doprecyzować tworzone przez niego treści.

#Protip: na podstawie takiego zadania jesteśmy w stanie wywnioskować, czego chatGPT nie rozumie oraz o jak precyzyjnych zapytaniach jest mowa.

- Odpowiadamy na pytania, możemy też sprecyzować nasze oczekiwania.

Jest to świetny sposób na oszczędzenie czasu i budżetu. Na wejściu piszemy prosty, krótki prompt, który sam chatGPT rozbudowuje i pozyskuje informacje potrzebne do klarownej i spójnej odpowiedzi.

Mamy również dostępne narzędzia, takie jak PromptPerfect, które proste zapytanie przeorganizują w bardziej złożone, które zawierają więcej wytycznych dla naszego modelu.

Eksploracja i eksperymenty

Chat GPT to nie jedyne narzędzie wykorzystujące AI.

- Code Interpreter w GPT-4 – to narzędzie umożliwia interakcję z kodem w prosty sposób. Przesyłasz pliki, wydajesz polecenie, a model czyta, analizuje i prezentuje kod.

- Claude – jeszcze nie jest dostępny na rynku polskim. Oferuje 100 tysięcy tokenów, co pozwala na napisanie obszernego tekstu jednym pytaniem, umożliwia przesyłanie pliku i dostarcza dotyczących go odpowiedzi. Twórcy postawili sobie za cel całkowite wykluczenie halucynacji, czyli fałszowania odpowiedzi.

- GPT Engineer – tworzy plik z kodem na podstawie prostych instrukcji. Posiada również benchmarki, które dostarczają przykładowych rozwiązań w celu lepszego zrozumienia jego potencjału.

Podsumowanie

Można przypuszczać, że AI nauczyła się już połowy internetu, a to właśnie dzięki informacjom w nim zawartym rozwijała się do tej pory. Skalowanie modeli wzbudza wiele wątpliwości. Spekulacje wskazują, że w wypadku GPT-4 rozważa się trylion parametrów, na których uczyła się maszyna. Czy więcej parametrów oznacza zawsze lepszy model? Czy ilość parametrów jest jedynym kluczem do doskonałej wydajności? Czy istnieje ograniczenie, które wynika z ilości parametrów, a może ograniczenie leży w wydajności sprzętu? To pytania, które pozostawiają pole do spekulacji.

Wszystkie te nowe możliwości zachęcają do eksploracji i eksperymentów. Zastosowania są liczne, od generowania treści SEO poprzez analizę tekstów aż do tworzenia kodu, jednak warto zachować zdrowy rozsądek i podchodzić do wygenerowanych odpowiedzi z ostrożnością. Mimo że modele te zdają się być wszechwiedzące, weryfikacja i eksperymenty na własną rękę to klucz do zrozumienia ich granic i możliwości.

Wchodzimy w erę zaawansowanych modeli językowych, które stwarzają nowe możliwości, ale także nowe wyzwania. Czy to w teorii, czy w praktyce, pozostaje wiele do odkrycia w świecie interakcji między człowiekiem a maszyną, gdzie słowa stają się mostem do nieznanego.

Dzielimy się wiedzą!

Sprawdź nasze darmowe webinary i skorzystaj z wiedzy ekspertów!