Po zapytaniu Google „ile jest stron w internecie” otrzymujemy informacje z różnych źródeł o blisko dwóch miliardach witryn. Trudno dokładnie powiedzieć, na ile dane te są poprawne, jednak nawet zakładając znaczny margines błędu, możemy przyznać że w sieci funkcjonuje ogromna liczba stron internetowych. Przynajmniej częściowo wynika to z faktu, że trudno sobie w dzisiejszych czasach wyobrazić dobrze prosperujący biznes bez własnej wizytówki w sieci. Google jako największa i najpopularniejsza wyszukiwarka na świecie dąży do przedstawiania jak największej ilości domen, które mogą być potencjalnie wartościowe dla użytkowników.

Jak więc łatwo się domyślić, zasoby pozwalające na skanowanie i indeksowanie tak dużej ilości treści w sieci muszą być ogromne. Oczywiście tak potężna firma jak Google dysponuje wielkimi możliwościami, jednak w dzisiejszym świecie bardzo istotna jest optymalizacja użycia pewnych zasobów, co jest bezpośrednio związane z kosztami, które ich wykorzystanie generuje. W związku z tym powstało takie pojęcie jak crawl budget, czyli liczba stron, które roboty wyszukiwarek są w stanie i chcą zindeksować na stronie w określonym czasie.

Spis treści

Budżet crawlowania – na czym polega ten proces?

Czym jest crawl budget? Tak jak wspomniałem na wstępie, budżet crawlowania to nic innego jak określona częstotliwość, z jaką crawlery i roboty wyszukiwarek mogą indeksować stronę, a także całkowita ilość adresów, które mogą crawlować jednorazowo. Crawl budget strony można przyrównać do „kredytów” lub „punktów”, które możemy zamieniać na korzyści w grach, aplikacjach lub usługach. W ramach naszych działań optymalizacyjnych na stronie musimy dbać o to, by liczba tych „kredytów” utrzymywała się stale na jak największym poziomie. Istotne jest tutaj również racjonalne korzystanie z tych zasobów, o czym przeczytasz w dalszej części tego artykułu. Budżet indeksowania odzwierciedla również poziom zainteresowania Google Twoimi treściami publikowanymi w sieci.

Crawl Rate Limit

Jest to jeden ze wskaźników wchodzących w skład budżetu crawlowania strony. Definiuje on to, jak często roboty wyszukiwarek mogą odwiedzać stronę internetową w celu jej indeksowania. Jest to istotne szczególnie pod kątem optymalizacji wydajności strony, która może ucierpieć w sytuacjach, gdy jest intensywnie crawlowana przez Goobleboty. Warto wiedzieć, że ingerowanie w Crawl Rate Limit może spowolnić indeksowanie treści na naszej stronie internetowej.

Crawl Health

To pojęcie odnoszące się do technicznych aspektów strony internetowej. Dla robotów Google istotne jest, by strona była maksymalnie wydajna, czyli szybko ładowała swoje zasoby. Dzięki temu Googlebot jest w stanie przeanalizować więcej podstron w ramach jednego crawlowania, co jak łatwo się domyślić, pozytywnie wpływa na statystyki indeksowania.

Crawl Demand

Jest to częstotliwość indeksacji, która wynika, chociażby z popularności strony internetowej oraz częstotliwości publikowania na niej nowych treści. Boty Google najchętniej odwiedzają strony, które są popularne wśród użytkowników. O tym aspekcie świadczy ruch na stronie, ale również liczba linków, które prowadzą do danej domeny z innych stron internetowych.

Dlaczego budżet crawlowania jest istotny dla SEO?

Crawl budget, a w zasadzie jego optymalizacja i wykorzystanie pełnego potencjału, jest bardzo istotne dla SEO. Indeksowanie witryny sprawia, że jej treści docierają do Google, a następnie w formie rankingu ustalana jest ich pozycja i później trafiają do użytkowników. Jakiekolwiek problemy z crawlowaniem strony internetowej mogą negatywnie wpływać na indeksację treści.

Im gorzej będziemy wykorzystywać crawl budget naszej strony internetowej, tym rzadziej indeksowane będą nasze treści. Może się to przekładać na duże opóźnienia w czasie, w którym Google będzie prezentował w swoich wynikach wyszukiwania naszą domenę. W skrajnych przypadkach może dojść do sytuacji, w której robot Google wcale nie dotrze do nowych treści, a wtedy stracimy jakiekolwiek szanse na wyświetlanie się w SERP’ach, nawet jeśli nasze pozostałe działania SEO będą prowadzone w sposób wzorowy.

Optymalizacja crawl budget powinna być więc istotnym elementem naszej kampanii SEO. Czasem wystarczy wykonanie kilku prostych kroków, by utorować robotom Google drogę do treści i podstron, na których nam zależy najbardziej.

Nie trać klientów przez błędy SEO!

Zleć audyt SEO i dowiedz się, co poprawić

Jakie czynniki wpływają na crawl budget?

To, w jaki sposób nasza strona będzie wykorzystywać swój crawl budget, w dużej mierze zależy od nas samych. Warto o tym myśleć najlepiej jeszcze podczas projektowania witryny lub na etapie wdrażania większych zmian w jej architekturze, wyglądzie czy technikaliach. Poniżej kilka przykładów czynników, które mogą realnie wpływać na crawl budget witryny:

- Rozmiar strony internetowej – im większa jest strona internetowa, tym Googlebot potrzebuje więcej czasu oraz zasobów na jej przeanalizowanie. Warto więc tworzyć możliwie jak najbardziej kompaktowe witryny, które pozwolą na oszczędności w tym zakresie.

- Stopień duplikacji treści – powielająca się w kilku miejscach na stronie treść nie niesie żadnej korzyści dla Google. Może więc dojść do sytuacji, że Google trafiając na często powielające się treści, zrezygnuje z indeksowania przynajmniej części z nich.

- Wydajność strony – jeśli problemem naszej strony jest szybkość, to musimy spodziewać się, że roboty Google będą musiały poświęcać więcej czasu na każdy adres URL, co niekorzystnie wpłynie na cały proces indeksowania treści.

- Błędy 404 – indeksowalne strony o statusie 404 będą przynajmniej w pewnym stopniu marnować nasz budżet crawlowania. Każdorazowo, gdy bot trafi na taką podstronę, wykorzysta zasób, który w tym samym czasie mógłby poświęcić na przeanalizowanie znacznie bardziej wartościowej podstrony.

- Przekierowania – każde przekierowanie działające na schemacie „adres z przekierowaniem > adres docelowy” wykorzystuje zasoby, które w normalnych warunkach Google mógłby przeznaczyć na zaindeksowanie dwóch podstron. Warto dodać, że często mamy do czynienia z łańcuchami przekierowań, które wykorzystują budżet w jeszcze większym stopniu.

- Wdrożenie pliku sitemap.xml – jest to bardzo przyjazna dla botów Google forma agregatora linków wewnętrznych, dzięki którym może sprawnie i łatwo docierać nawet do głębiej ukrytych w strukturze podstron.

- Częstotliwość aktualizacji treści – jest bardzo istotna pod kątem przyspieszenia crawlowania domeny. Im częściej nasze treści będą aktualizowane, tym częściej Google będzie je odwiedzał.

- Linkowanie wewnętrzne – służy jako nawigacja nie tylko dla użytkowników, ale również robotów indeksujących. Warto więc unikać powstawania różnego rodzaju „ślepych uliczek” czy „osieroconych podstron”, do których dotarcie może być problematyczne.

- Plik robots.txt – jego przeznaczeniem jest zarządzanie ruchem botów indeksujących po naszej stronie internetowej. Za jego pomocą przekazywane są informacje, do których adresów URL w witrynie roboty mogą uzyskać dostęp, a których nie powinny w żaden sposób indeksować.

Powyższa lista jest stosunkowo długa i może martwić administratora strony. Warto jednak pamiętać, że wdrażając powyższe optymalizacje, wpływamy nie tylko na wydajność crawlowania naszej domeny, ale także na nasze SEO i jego wyniki.

Jak analizować crawl budget swojej witryny?

Jak już ustaliliśmy, budżet crawlowania jest bardzo istotnym elementem naszych działań SEO. Jeśli zależy nam na jak najlepszych pozycjach strony w Google, to warto raz na jakiś czas dokonywać przynajmniej podstawowej analizy crawl budgetu. Na co zwrócić szczególną uwagę i jakimi narzędziami warto się wspierać?

Analiza przy pomocy Google Search Console

Świetnym przykładem narzędzia, które może nam wiele powiedzieć o budżecie crawlowania, jest Google Search Console. Znajdziemy tam najbardziej wiarygodne i precyzyjne informacje na ten temat, a także będziemy w stanie monitorować najważniejsze elementy w ujęciu czasowym, co jest szczególnie istotne podczas prowadzenia kampanii SEO.

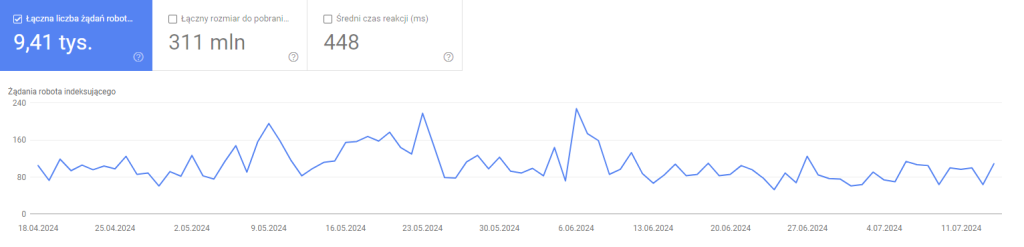

Na szczególną uwagę zasługuje raport „Statystyki indeksowania”, który znajdziemy w zakładce „Ustawienia”. Możemy tam znaleźć sporo przydatnych informacji o ilościach żądań robotów indeksujących, średnim czasie reakcji, odpowiedziach, jakie uzyskał bot, a także typach plików czy celach wykonanych zapytań. Bardzo przydatny jest również wykres prezentujących powyższe dane w ujęciu czasowym, co pozwala nam na odnalezienie ewentualnych anomalii. Przykładowy wygląd raportu znajduje się poniżej.

W Search Console jesteśmy w stanie znaleźć wiele innych, bardzo ciekawych informacji. Warto również dokładniej przyjrzeć się raportom z sekcji „Indeksowanie” oraz „Eksperymenty i personalizacja”. To właśnie dzięki zebranym tam danym możemy dowiedzieć się nieco więcej na temat ogólnej kondycji naszej strony internetowej. Jest to szczególnie istotne wtedy, gdy wykonujemy audyt SEO, czy przygotowujemy szerszą analizę i chcemy zwrócić uwagę na wiele różnych aspektów.

Analiza z wykorzystaniem narzędzi crawlujących

Popularne crawlery, takie jak Screaming Frog czy Sitebulb, mogą być również bardzo pomocnymi narzędziami w analizie strony pod kątem optymalnego wykorzystania crawl budgetu. Za ich pomocą możemy skutecznie badać i analizować takie technikalia witryny jak: błędy 404, przekierowania, wydajność strony, linkowanie wewnętrzne czy stopień duplikacji treści. Dane, które możemy w ten sposób uzyskać, są bardzo przydatne do optymalizacji strony oraz naprawiania ewentualnych błędów.

Weryfikacja logów serwera

Analiza logów serwera pozwala nam na śledzenie ruchu oraz zachowań botów Google. W ten sposób jesteśmy w stanie określić, czy w ostatnim okresie zachodziły jakieś zmiany, czy boty docierały do wszystkich podstron w naszej domenie, a także czy nie pojawiały się chwilowe anomalie, np. nagły wzrost lub szybki spadek ruchu botów indeksujących. Analizując logi serwera, warto brać pod uwagę nieco dłuższy okres, np. miesiąc lub dwa. W przypadku większych witryn o dużej ilości podstron często wystarczający okazuje się okres ostatnich dwóch tygodni.

Optymalizacja crawl budgetu krok po kroku

Optymalizacja crawl budżetu jest istotnym elementem naszej kampanii SEO. Na szczęście w większości przypadków nie wymaga ona żadnych skomplikowanych działań, a opiera się na wprowadzeniu poprawek w zakresie elementów, nad którymi i tak bardzo często pracujemy w ramach pozycjonowania strony. Poniżej znajduje się krótka lista działań, które warto zrealizować, a które mogą pozytywnie wpłynąć na nasz crawl budget.

- Likwidacja błędów 404 i weryfikacja przekierowań – w świecie idealnym warto dążyć do tego, by nasza strona nie generowała 404. W przypadku większych sklepów internetowych czy portali jest to w zasadzie niemożliwe, lecz dobrą praktyką jest ograniczanie ich ilości do minimum. Podobnie jest w przypadku przekierowań. Jeśli jesteśmy w stanie wyeliminować ich nadmiar lub znacząco ograniczyć ilość, np. przez usunięcie przekierowań łańcuchowych, czy zaktualizowanie linkowania wewnętrznego, to warto się tym zająć.

- Wdrożenie pliku robots.txt i sitemap.xml – robots.txt pozwala na zarządzanie ruchem botów indeksujących Google, co jest szczególnie istotne, gdy na naszej stronie znajdują się treści, które nie powinny trafiać do indeksu wyszukiwarki. Wdrożenie tego pliku na stronie jest prostym działaniem, które usprawnia proces indeksacji treści. Podobną rolę ma sitemapa. Dzięki niej Google jest w stanie łatwiej docierać do pełnej listy adresów, na których indeksacji nam zależy.

- Poprawienie wydajności strony – im bardziej wydajna i szybka będzie nasza strona internetowa, tym Google w ramach jednego crawla będzie w stanie odwiedzić więcej podstron. Jeśli natomiast będzie miał on duże problemy z analizowaniem zawartości naszej witryny, to może to powodować znaczne spowolnienie indeksacji treści, a w niektórych przypadkach może się to przełożyć również na widoczność i ruch na stronie. Strona jest wolna i powoli się ładuje? Wykonaj analizę w PageSpeed Insights i popracuj nad elementami, które pomogą w jej przyspieszeniu.

- Unikanie duplikacji treści – Google w Twojej witrynie szuka treści, które mogą być wartościowe dla użytkowników. Trudno to powiedzieć o zawartości, która jest regularnie powielana i powtarza się kilkukrotnie w obrębie naszej domeny. Pozbycie się duplikacji treści pozwoli nam nie tylko na poprawę crawlowania domeny, ale również podniesie nasze pozycje w wynikach wyszukiwania. Widzisz na swojej stronie zduplikowaną treść? Poddaj ją szybkiemu recyklingowi lub przynajmniej zastosuj w odpowiedni sposób tagi kanoniczne.

- Optymalizacja linkowania wewnętrznego – element ten warto traktować jako formę nawigacji po stronie internetowej. Powinna być ona przyjazna nie tylko dla użytkowników, ale również dla botów. W szczególności dla tej drugiej grupy powinna stanowić formę priorytetowania poszczególnych treści, a także umożliwiać szybkie poruszanie się po różnych adresach URL w obrębie naszej witryny. Unikajmy więc za wszelką cenę ukrytych dla botów linków wewnętrznych czy odnośników nieposiadających anchorów w formie dopasowanych fraz kluczowych.

Oczywiście nie są to jedyne działania, które możemy podjąć w celu poprawy szybkości crawlowania naszego serwisu. Warto jednak rozpocząć swoje prace od tych właśnie działań, ponieważ ich realizacja nie jest skomplikowana, a może przynieść wymierne efekty.

Zoptymalizuj crawl budget i popraw wyniki swojej strony!

Po zapoznaniu się z treścią tego artykułu już pewnie wiesz, że crawl budget wpływa na SEO. Warto więc go potraktować jako element strategii SEO i podobnie jak w przypadku zagadnień analizowanych w ramach audytu, wdrożyć rozwiązania pozwalające na jego optymalizację. Odpowiednie dysponowanie i zarządzanie crawl budgetem może nam przynieść duże korzyści, które pozwolą na osiąganie zdecydowanie lepszych pozycji w Google.