Na warsztat dobrego audytora składa się wiele narzędzi i choć praca powinna odbywać się na żywym organizmie, często przy użyciu konsoli programisty to wielu rzeczy nie da się sprawdzić bez dobrego crawlera.

Prawda jest taka, że im więcej programów tego typu uruchomimy tym większa szansa na wykrycie błędów. Dodatkowo dobry crawler pozwala na własne testy, dla przykładu zbadanie strony pod kątem obecności kodu Google Analytics na każdej stronie czy wykryciu stron z konkretną treścią. Dla stron o ogromnej liczbie podstron (>100.000) skanowanie jakimkolwiek narzędziem online nie wchodzi w grę, większość narzędzi sobie albo nie radzi albo cena za stałe używanie takiego narzędzia jest odstraszająca. Tu liczy się szybka i sprawdzona aplikacja desktopowa, a taką właśnie jest WebsiteAuditor z pakietu Link-Assistant.com.

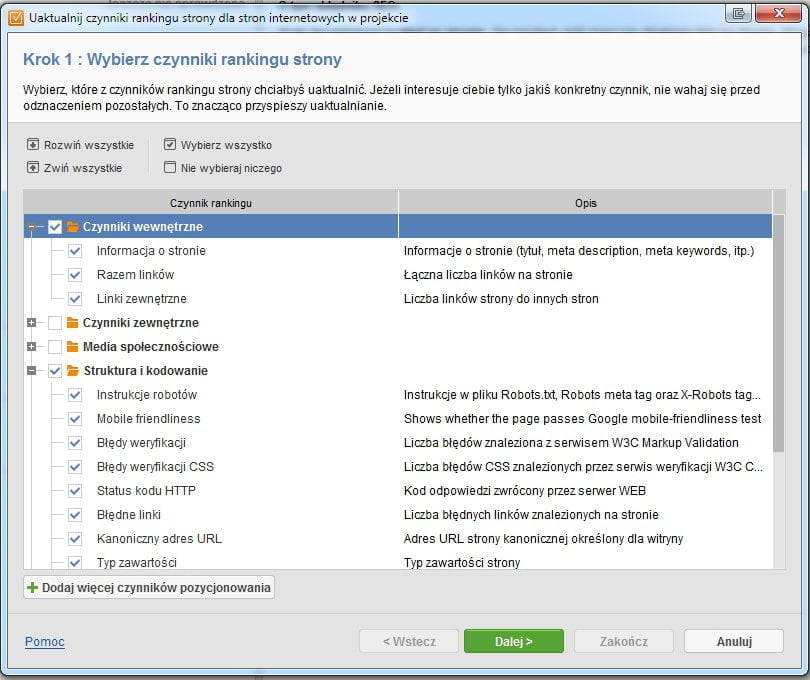

Aby uruchomić projekt musimy podać adres naszej strony. System radzi sobie ze stronami ukrytymi za hasłem serwera. Podczas skanowania możemy sami zdefiniować jego zakres i np.: pominąć czynniki zewnętrzne i media społecznościowe co skróci czas pracy narzędzia.

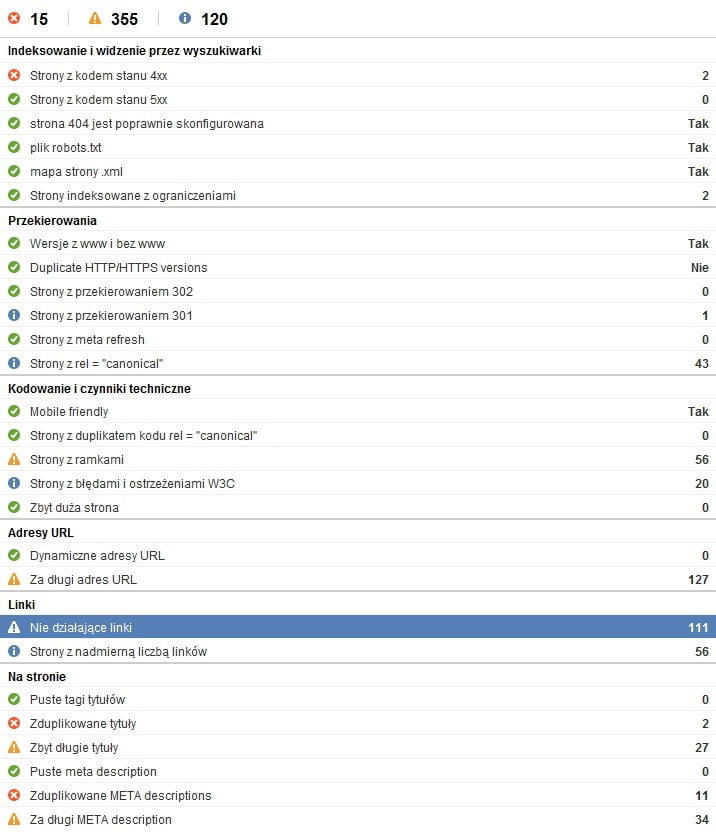

Nie mogło tu zabraknąć typowego nic nie wnoszącego raportu, ale nie na tym będziemy się skupiać. Raporty szczegółowe są bardzo sensowne:

Jak widać mamy mnóstwo gotowych testów i elementów, za które można się zabrać. Część informacji to tylko ostrzeżenia, ale twórcy narzędzia zastosowali odpowiedni podział za pomocą ikon. Stąd najważniejsze kwestie są od razu wyróżnione. Pojawiają się tu też małe nieścisłości typu sprawdzanie błędów W3C albo informacje o ramkach, przy czym wprawny specjalista SEO będzie wiedział co ignorować a co dokładniej sprawdzić.

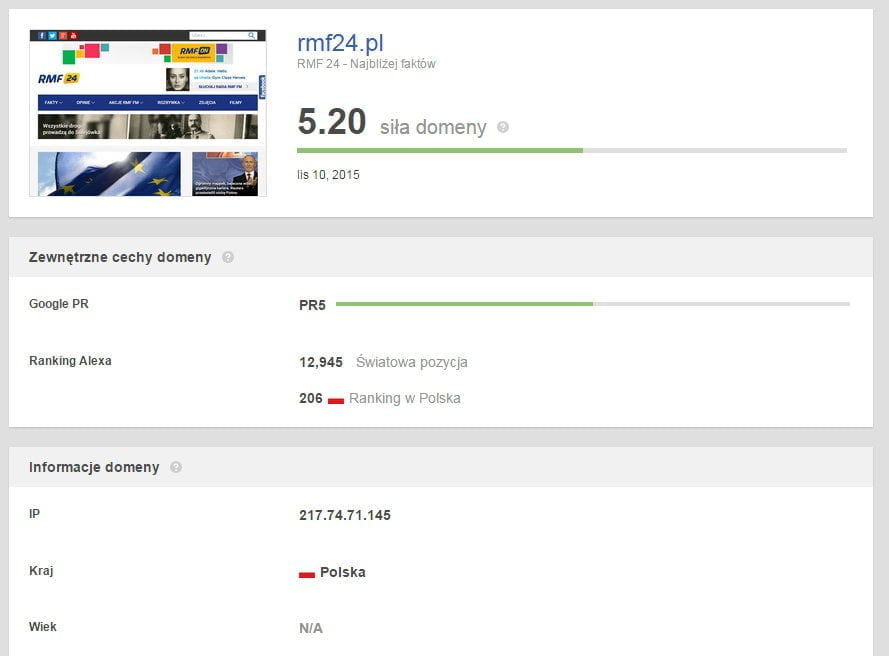

W każdym z raportów możemy podglądnąć szczegóły i pobrać dodatkowe informacje do każdego pobranego adresu URL. Tak zbudujemy raporty szczegółowe.

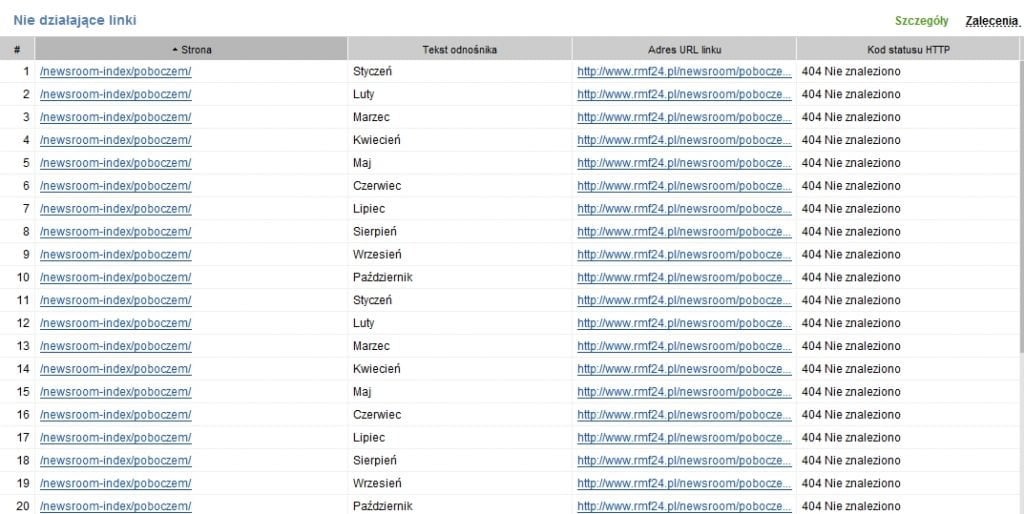

Pełna lista stron z niedziałającymi linkami. Nie chcemy ich z dwóch powodów, jeden to Googlebot sypiący błędami w Search Console a drugi to zagubieni użytkownicy.

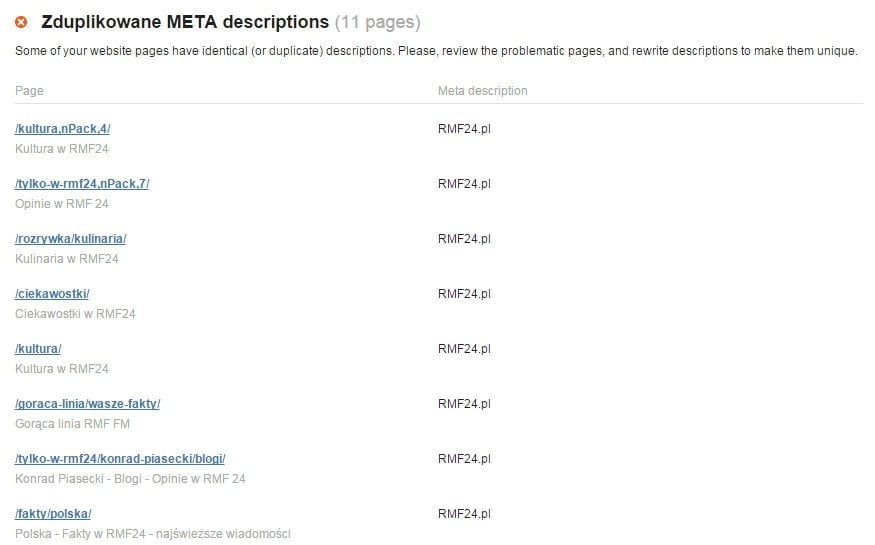

Dla przykładu kolejny raport – zduplikowane description to nie jest wielki problem, ale raport pokazuje gdzie moglibyśmy bardziej wykorzystać potencjał tego tagu. Choć nie wpływa na pozycje sam w sobie, to można jego budową delikatnie podnosić CTR wyników organicznych.

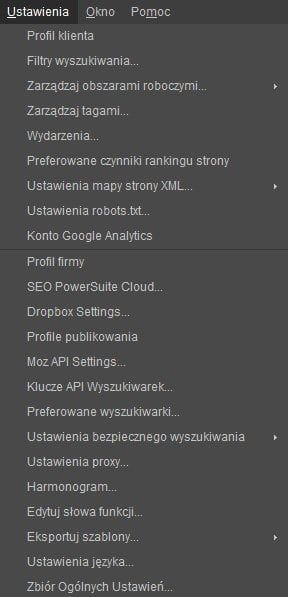

Na koniec prezentacja opcji programu – od API wyszukiwarek i MOZ po ustawienia proxy. Pojawią się tu też takie ustawienia, które pozwalają na bardzo zaawansowaną modyfikację założeń projektu. Jeśli chcemy ze skanów wykluczyć pozorne błędy lub wyszukać coś, co nie zostało typowo zdefiniowane w programie, pomogą nam m.in filtry wyszukiwania. Narzędzie potrafi wygenerować również mapę XML na potrzeby Google.

Podsumowując WebSite Auditor to zaawansowany crawler, narzędzie, które porusza się po naszej stronie wzorem robotów wyszukiwarek. Potrafi w bardzo prosty i szybki sposób wygenerować zestawienie błędów i ich detale. To obowiązkowe narzędzie w warsztacie osoby audytującej strony pod względem SEO.